컴퓨터활용능력 1급 필기 정보 및 합격후기 바로가기

https://beaver-sohyun.tistory.com/22?category=833031

컴퓨터활용능력 1급 필기 합격후기(단기 독학, 컴활 소개정보)

3학년 2학기가 끝난 후 작은 비버는 뭘 할까 고민하다 자격증을 따기로 결심함. 뭘 준비해야할까 고민중 컴퓨터활용능력 1급을 따기로 결정 예전에 한 번 따보려고 노력해봤다가 중간에 포기한 �

beaver-sohyun.tistory.com

컴활 1급 실기 종목 소개 및 정보

https://beaver-sohyun.tistory.com/42?category=833031

컴퓨터활용능력 1급 실기 (종목소개 및 시험 정보, 가격, 접수방법)

안녕하세요호~ 엄청엄청 오랜만입니다~~~ 드디어 미루고 미뤘던 컴활 1급 실기 합격 후기를 가지고 왔습니다..!!! 필기 합격한 후기를 올린지 몇달이 지난 후에야 드디어 가져오다니... 이번 일을

beaver-sohyun.tistory.com

안녕하세요~ 재빠르게 돌아온 작은비버입니다.

오늘은 컴활 1급 실기 합격 후기를 들고왔습니다!!!!

나의 두번째 자격증,,, 훗

-비버의 자격증 보유 현황(GTQ 1급, 컴활 1급)

-차차 채워나갈 예정(너무 놀았네,,;;;)

저는 일단 컴활 1급 실기가 아주아주 어렵다는 이야기를 듣고 지레 겁을 먹었죠,,

그래서 막 찾아보다 '아이티 버팀목 유동균'강사님 강의만 들으면 백퍼 합격이라는 말을 듣고 수강을 했쬬....^^

아이티 버팀목 사이트

컴퓨터자격증 전문 사이트 IT 버팀목

시험소개 및 학습법 소개 컴퓨터 활용능력 1급 단기과정 필기 실기 1급 정규과정 필기 실기 2급 단기과정 필기 실기 2급 정규과정 필기 실기 워드프로세서 1급 단기과정 필기 실기 1급 정규과정 ��

www.itbtm.com

컴퓨터활용능력 1급(단기) 실기

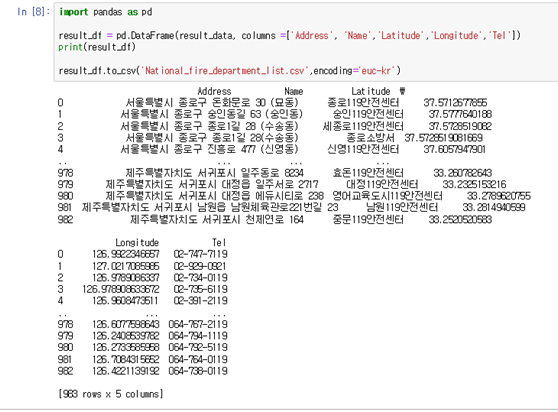

전 이미 필기는 독학으로 합격했기에 '컴퓨터 활용능력 1급 단기 실기'를 수강신청했습니다.

컴활 말고도 다양한 자격증이 있으므로 참고하실 분들은 참고하시길..!!

- 수강기간 기본 60일 + 무료연장 1회 60일 = 총 120일(4개월)

- 전 이게 제일 메리트라고 생각합니다ㅜㅜㅜㅜ 대학생분들은 학기 중에 자격증을 취득하기 어려워서 시간을 버리는 경우가 있는데 수강기간이 끝난 후 학기를 마치고 방학 중에 무료연장을 통해 다시 수강할 수 있다는게 장점이죠!!

- 저 역시 필기는 1월에 합격하고 탱자탱자 놀다 무료연장을 통해 컴활 1급 실기(단기)를 재수강 했습니다...^^

- 가격 70,000원

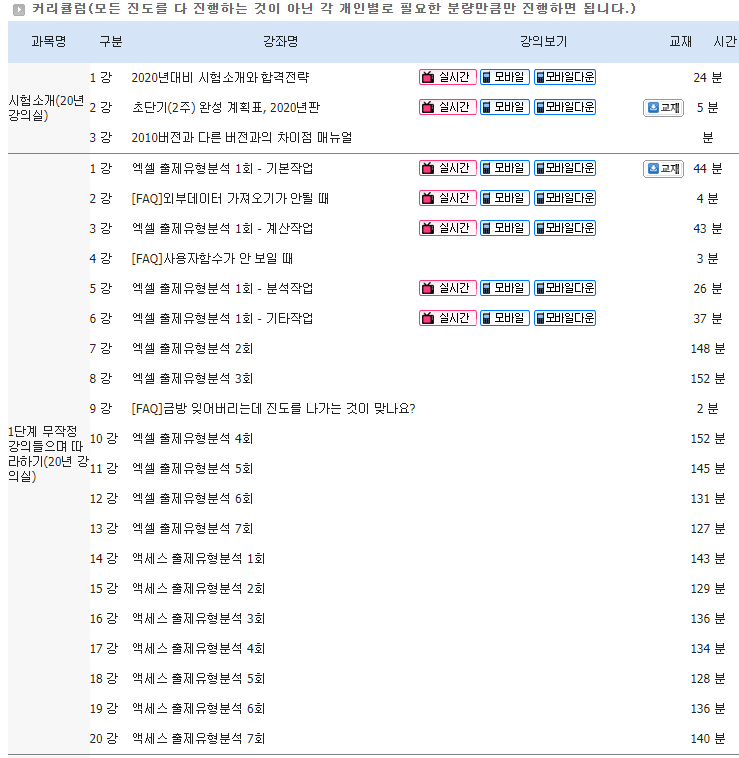

- 강의수 63강의(강의당 시간 60분 내외)

- 여기서 제일 힘들었습니다.. 강의가 정말 길어서 처음에는 진짜 치졌어요..

- 아이티 버팀목을 수강하길 망설였던 이유 중 하나도 일단 강의시간,, 강의수,,,,

- 하지만 듣고나면 진짜 생각달라지무ㅜㅜㅜㅜㅜ

- 고민되는 분들은 무료강의 한 번 들어보시는거 추천드려요!!

- 강사님의 수업 스타일이랑 잘 맞는게 제일 중요해요!!!

- 교재는 따로 사지 않고 강의 내에 제공하는 파일들로 공부 및 수강했습니다.

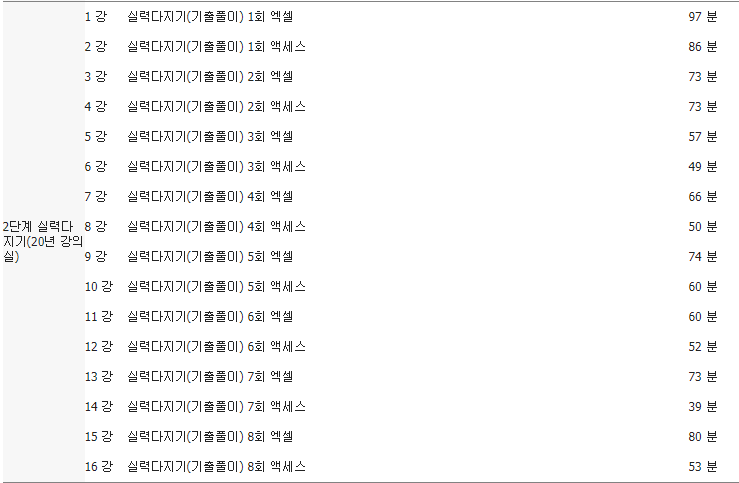

컴활 1급 실기(단기) 강좌 커리큘럼

- 추천하는 방법은 1단계 무작정 듣고 -> 3단계!!

- 일단 기본 강의 시간이 2시간 정도 되는데 강사님 말이 좀 느린 편이기도 해서 저는 2배속으로 해서 들었습니다.(그래도 1시간 넘음...^^)

- 1단계 들으면서 그냥 무작정 강의 보면서 따라했습니다.(어려웠던 부분은 뒤로가기 해서 한 번씩 다시 돌려보기)

- 필기는 따로 안하고 그냥 진짜 들으면서 따라했습니다.(모의고사는 제공해주심 그냥 엑셀과 엑세스만 있으면 돼요!)

- 엑셀을 계속해서 듣고 그 다음 엑세스를 계속해서 듣는 방식으로 진행

- 모바일로도 수강 가능합니다.(star player+ 앱 다운받으시면 돼요)

- 2단계는 듣지 않았습니다.

- 유동균 강사님께서 원하시는 방식은 1단계 -> 3단계로 바로 넘어가기!

- 2단계는 계속해서 자격증에 떨어지거나 시간이 많이 남으시는 분들에게 추천합니다.

- 대망의 3단계!!

- 1단계는 본격적으로 공부하기 예전에 들은거라서 기억이 1도 안나는 상태로 공부를 시작

- 처음 듣는 느낌이라서 2배속으로 해놓고 중간중간 어려웠던 부분, 헷갈렸던 부분들은 다시 보거나 필기하면서 봤습니다.

- 엑셀, 엑세스 한 회 순으로 강의가 진행되며, 여기서도 강사님이 자세히 설명해줍니다.

- 엑셀, 엑세스에서 나올 법한 여러 문제들을 보여주기 때문에 3단계만 여러번 반복하면 합격 가능성이 높습니다.

- 저는 3단계를 3회독 했습니다.

- 처음에는 그냥 듣기 1회독, 필기+다시 듣기 하면서 2회독, 3회독 때에는 혼자 문제 풀면서 어려웠던 부분, 헷갈렸던 부분 강의 듣기 3회독

- 일단 모의고사 자체가 많이 있어서 다양한 문제패턴들을 학습하면서 머릿속에 넣을 수 있었고 반복해서 내용을 알려주시기 때문에 더 좋았습니다.

- 강의를 듣는건 3회독 하고 문제만 푸는건 4번 정도 혼자 반복해서 풀었습니다.

- 일단 컴활 1급 자체가 어렵기도 해서 반복해서 하는게 제일 합격 가능성이 높은거라서 계속 반복!!

- 일단 강의가 길어서 초반 강의 들을때는 하루 5~7시간 정도 공부시간을 만들어야한다고 보시면 됩니다.

- 후에 문제만 풀때는 2회씩 반복해서 풀면서 시험시간대로 풀고 어려웠던 부분들 요약집 만들고 계속 반복해서 풀었습니다.

컴활 1급 실기(단기) 구매 시 -> 2급 특강도 수강 가능

- 1급 필기를 합격하고 난 후 2급 실기를 합격하면 컴활 2급 취득이 가능합니다.

- 컴활 1급 실기가 어려워서 대부분 포기하게되는데 그럴경우 2급 실기를 보셔서 2급이라도 취득하시는 것을 권장드립니다!

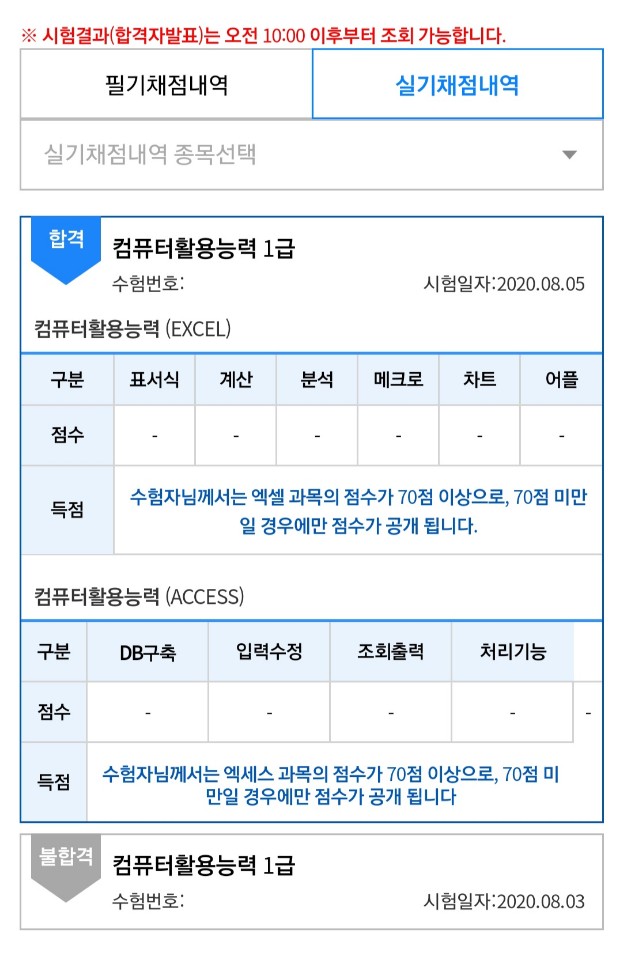

시험 결과 및 합격 인증

- 처음 시험 볼 때는 모르는 문제도 많았고 느낌이 딱 아 떨어지겠구나 들었습니다.

- 진짜 시험 보면 딱 느낌이 들어요, 그래서 시험 2번 이상 연속으로 접수하는거 추천드려요!

- 엑세스는 문제가 쉽게 나와서 통과!

- 저는 맨 앞에 2번째 줄 좌석이였는데 앞 좌석이 문제 쉽게 나온다 했는데 그건 아닌 것 같아요...(전 엑셀 부분이 어려웠습니다.)

- 그리고 엑셀, 엑세스 유동균 강사님이 올려주신 상설 문제에서 많이 나왔습니다!!!!!!!!!!!!!!

- 첫 시험 20.08.03에 친 후 이틀 뒤로 바로 접수

- 시험 치고 나서 다시 반복해서 문제를 풀고 엑셀 계산 부분이 약해서 그것만 따로 문제로 만들고 계속해서 풀었습니다.

- 시험장 가서는 제가 요약했던 요약집을 보면서 외워야 할 부분들은 암기하고 시험장에 들어갔습니다.

- 일단 시험을 보면서 20분 정도가 남아 한 2번 이상 검토하고 나왔습니다.

- 시험을 보면서 이거 백퍼 통과다 라는 느낌을 받았고, 문제는 정말정말 쉽게 나왔습니다.

- 좌석은 앞에서 4번째줄 좌석 이였습니다!!

- 역시 유동균 선생님께서 올려주신 상설 파일에서 많이 나왔습니다!!

- 아주 뿌------------듯

- 합격은 시험보고 난 후 2주 후에 나옵니다.

- 그때까지 아주 심장 쫄깃하게 지냈습니다.

후기

처음에는 컴활 1급이 정말 어렵다고, 상공회의소의 마지막 자존심이라고 하길래 지레 겁먹고 미뤘었는데 해본 입장으로는 전공자 이지만 비전공자이신 분들도 정말 100% 반복만 한다면 합격할 수 있다고 생각합니다.

일단 컴활은 무조건 반복!!!!!!!!!이 제일 중요한 것 같아요.

혼자 실기를 준비하기에는 컴활 실기 자체가 어려운 부분들도 많고 외워야 할 내용도 많아서 전문가의 도움을 받는 것 도 나쁘지 않다고 생각합니다.

너무 겁먹지 마시고 정말 반복 + 요약집 정리 + 강의 반복 수강 이렇게만 하시면 합격 가능성이 높으니 너무 겁먹지 마세요!!!

따고 나니깐 후련하기도 하고 이게 뭐라고 지레 겁먹었나 싶기도 하고~~~

저는 다음에 또 다른 자격증 후기로 돌아오겠습니다!!

긴 글 봐주신 비버 여러분 감사드립니다!!

강의를 수강하면서 어떤식으로 공부했나?!

1. 처음에는 1단계 그냥 진짜 들으면서 문제 따라하기

2. 1단계 후 바로 3단계로 돌입

3. 3단계는 3회독( 1회독 : 강의들으면서 문제 풀기, 2회독 : 강의 들으면서 어려웠던 부분, 헷갈린 부분들 다시 듣고 요약집 오답노트 만들기, 3회독 : 혼자 문제 풀면서 어려운 부분, 헷갈리는 부분, 틀린 부분 강의 다시 듣기)

4. 시험 시간에 맞춰 엑셀만 쫙 풀고, 엑세스 쫙 풀기(총 4회독)

5. 틀린 문제들은 오답노트 다시 만들고 외워야할 내용 요약집 만들기

6. 시험 전날에는 4회차 정도를 문제풀고 외우고 계속해서 반복

7. 시험장 앞에서는 외워야 할 내용들만 보고 들어갔음

8. 시험장에서 문제 나눠주고 대기할 때 빠르게 문제 훑기

9. 시험 시작하고 엑셀(1번 -> 3번 -> 4번 -> 2번 순), 엑세스(그냥 차례대로 풀기)

10. 엑셀에서 어려운 부분 빠르게 패스하고 계산문제까지 다 풀고나서 다시 보기

11. 엑세스는 빠르게 풀고 검토 많이 하기

중요한 것

1. 강의는 반복해서 수강할 것(강의 3회독 + 문제 4회독)

2. 요약집 및 틀린 문제 따로 정리하기

3. 시험 접수는 무조건 3회 이상 연속으로 접수하기(2~3일 단위로) + 자신감 있는 분들은 2번 이상 접수....?

4. 시험장 들어가서는 자료 못보니 그 전에 많이 봐두기

5. 어려운 부분이나 포기해야할 부분은 깔끔히 포기하기(ado객체, 매크로 등등)

6. 혼자 공부하는 시간 초반에는 하루 5~7시간 잡고, 그 후에 문제만 풀때는 3~4시간 잡기

2020.09.02 추가++++++++++++++++++++++++++

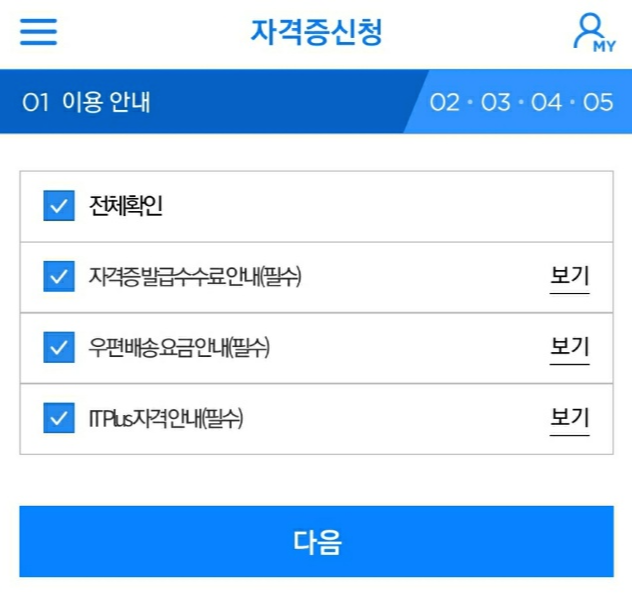

합격하고 나서 바로 코참패스 어플로 자격증 신청을 했습니다.

자격증은 합격한 사람만 신청할 수 있습니다.

- 수수료는 인터넷 3,100 + 우체국 등기배송료2,800원으로 총 5,900원 입니다.

- 신청 후에 10~15일 이내 소요(진짜 기다리면서 아주 그냥 마음이 초초 했음.. 내 자격증 잘 오고 있는거니..?)

자격증 신청 -> 자격증 신청 클릭

전체 확인 클릭클릭 -> 다음

본인 신청하려고 하는 자격증 클릭클릭 -> 다음

- 저는 8월 21일날 신청했습니다!

아주 시간이 지나고 지나 오늘 드디어 9월 2일 등기로 배송받았습니다!!! 저는 12일 후에 배송받았습니다. 진짜 기다리는 내내 힘든 시간이였습니다..ㅜㅜㅜ 그래도 받고 나니깐 너무 기분이 좋아요ㅜㅜ 자랑스럽다 컴활 1급!!!!1

저기 크게 1급이라고 박혀있는데 사진이 너무 흐리죠...? 네... 일어나자마자 찍어서 그뤠요...ㅎ

그래도 이렇게 크게 '합격을 축하합니다.'라는 문구의 우편물을 받으니 그동안 고생했던게 확 풀리네요 ㅎㅎㅎㅎㅎㅎ

어서와 나의 컴활1급 자격증!!!!

이제 넌 내 평생 자격증이야!!!!!!!!!!!!!!!!!!!!!!!!

'작은비버의 성장과정 > 자격증' 카테고리의 다른 글

| 컴퓨터활용능력 1급 실기 (종목소개 및 시험 정보, 가격, 접수방법) (0) | 2020.08.26 |

|---|---|

| 컴퓨터활용능력 1급 필기 합격후기(단기 독학, 컴활 소개정보) (0) | 2020.01.28 |