안녕하세요, 작은 비버입니다!

오늘은 코로나바이러스에 대한 사회적 반응 중 하나인 '지하철 승객 수의 변화'에 대해 알아보려 합니다.

작은 비버는 코로나바이러스가 터지고 나서 궁금증이 하나 생겼습니다

'코로나바이러스가 터지고 나서 사람들이 정말 밖에 안 나올까? 사회적 거리두기를 잘 실천하고 있을까?'

이런 궁금증을 가지고 이번 과제를 수행하게 되었습니다.

사용한 지하철 데이터는 2019~2020년도 서울, 대구입니다.

대구 지역을 선택하게 된 이유는 코로나바이러스가 지역사회로 퍼지기 시작한 게 신천지 신도(31번 확진자) 이후입니다.

31번 확진자 이후, 대구시의 코로나바이러스 확진자는 무섭게 늘어났습니다.

이에 따라 대구 사람들의 지하철 이용 변화를 보기 위해 대구 지하철 데이터를 선택하게 되었습니다.

<사용한 외부 데이터>

1. kaggle Data Science for COVID-19 (DS4C) - TimeProvince.csv(전국 단위 누적 확진자 수 데이터 사용)

Data Science for COVID-19 (DS4C)

DS4C: Data Science for COVID-19 in South Korea

www.kaggle.com

2. 서울 열린 데이터 광장 - 서울시 지하철 호선별 역별 승하차 인원 정보

교통카드(선후 불교 통카드 및 1회용 교통카드)를 이용한 지하철 호선별 역별(서울교통공사, 한국철도공사, 공항철도, 9호선) 승하차 인원을 나타내는 정보입니다. (일단위)

https://data.seoul.go.kr/dataList/OA-12914/S/1/datasetView.do

열린데이터 광장 댓글 입력

열린데이터 광장 데이터셋 댓글 입력

data.seoul.go.kr

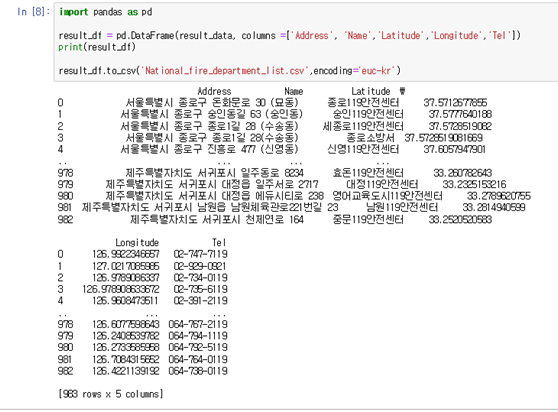

3. 대구 도시철도공사 - 대구 도시철도 승하차 인원 현황

www.daegu.go.kr/index.do?menu_id=00000122

<코로나바이러스 2020년도 첫 국내 확진자 날짜>

국내 1/20

서울 1/27

대구 2/18

사용한 데이터

- 서울 누적 확진자 수(2020.01~03)

- 대구 누적 확진자 수(2020.01~03)

- 지하철 승차 총 승객수(2019/2020.01~03) - 서울, 대구

seoul_confirmed = pd.read_csv('/root/corona/sohyun/metro_data/seoul_confirmed.csv', encoding='CP949')

daegu_confirmed = pd.read_csv('/root/corona/sohyun/metro_data/daegu_confirmed.csv', encoding='CP949')

seoul_202001 = pd.read_csv('/root/corona/sohyun/metro_data/seoul_202001.csv', encoding='utf-8')

seoul_202002 = pd.read_csv('/root/corona/sohyun/metro_data/seoul_202002.csv', encoding='utf-8')

seoul_202003 = pd.read_csv('/root/corona/sohyun/metro_data/seoul_202003.csv', encoding='utf-8')

seoul_201901 = pd.read_csv('/root/corona/sohyun/metro_data/seoul_201901.csv', encoding='utf-8')

seoul_201902 = pd.read_csv('/root/corona/sohyun/metro_data/seoul_201902.csv', encoding='utf-8')

seoul_201903 = pd.read_csv('/root/corona/sohyun/metro_data/seoul_201903.csv', encoding='utf-8')

- 서울 누적 확진자 수(2020.01~03)

- 대구 누적 확진자 수(2020.01~03)

- e.g., 서울 지하철 승차 총 승객수, 하차 총 승객수(2020.01)

저는 승차, 하차 데이터 중, '승차 총 승객수'데이터를 사용했습니다.

승차 데이터는 그 지역에서 사람들이 외부로 나가는 것을 확인할 수 있는 수치

하차 데이터는 외부에서 그 지역으로 사람들이 들어오는 것을 확인할 수 있는 수치

여기서 저는 그 지역 사람들이 외부 활동을 하는지에 대한 변화를 확인해보고 싶었기에 '총 승차 승객수' 데이터를 사용했습니다.

1. 서울 지하철 승차 총 승객수(2019/2020.01~03)

(주말, 공휴일 포함)

date : 1 ~ 31일 기준(제일 긴 일수로 맞춤)

total_count : 1,000,000 ~ 10,000,000

파랑 : 1월

주황 : 2월

초록 : 3월

지하철 승차 총승객수의 변화를 알아보기 전에 2019년도 같은 월(01~03)에는 어땠는지 확인해봤습니다.

2019년도에는 1월에서 3월 모두 전체의 흐름이 비슷했습니다.

2020년도에는 1~3월까지의 승차 총승객수가 확연히 줄어든 것을 보실 수 있습니다.

2020년도에는 1/24~27일이 공휴일인 점을 감안해도, 서울 첫 확진자(1/27)가 나온 이후로는 1~3월 모두 승차 총승객수의 변화가 있는 것을 보실 수 있습니다.

2020년 3월에는 2019년도 3월보다 승차 총승객수의 변화가 급감한 것을 보실 수 있습니다.

seoul_2020_Data = pd.concat([seoul_202001,seoul_202002,seoul_202003],ignore_index=True,axis = 0)

seoul_2019_Data = pd.concat([seoul_201901,seoul_201902,seoul_201903],ignore_index=True,axis = 0)

plt.title('2019/2020 01~03 Total number of passengers on the subway')

plt.xlabel('date')

plt.ylabel('total_count')

plt.plot(seoul_2019_Data['승차총승객수'],label="201901~03")

plt.plot(seoul_2020_Data['승차총승객수'],label="202001~03")

plt.ylim([1000000,10000000])

plt.legend()2019/2020년 1월에서 3월까지 한눈에 보기 위해 날짜를 쭉 합쳐서 그래프를 그려보았습니다.

파란색 선이 2019년 1~3월까지의 전체적인 승차 총승객수의 변화

주황색 선이 2020년 1~3월까지의 전체적인 승차 총 승객수의 변화

2019년도에 비해 2020년도에는 서울 첫 확진자(1/27) 이후 승차 총승객수가 점점 줄어드는 것을 보실 수 있습니다.

2. 누적 확진자 수에 따른 서울 지하철 승차 총승객수의 변화(2020.01~03)

(주말, 공휴일 포함)

국내 첫 확진자(1/20), 서울 첫 확진자(1/27) 이후에 누적 확진자 수에 따른 지하철 승차 총 승객수의 변화를 알아보았습니다.

왼쪽 축은 지하철 승차 총 승객수

오른쪽 축은 누적 감염자 수

파란색 선은 2019년도 지하철 승차 총 승객수

주황색 선은 2020년도 지하철 승차 총 승객수

누적 확진자 수에 따른 지하철 승차 총 승객수의 변화입니다.

2019, 2020년도 모두 국내 첫 확진자(1/20) 이전에는 대체로 비슷한 흐름으로 지하철 승차 총 승객수의 변화를 보입니다.

서울 첫 확진자(1/27) 이후로는 2019년도에 비해 2020년도에 지하철 승객수의 변화가 줄어드는 것을 보실 수 있습니다.

신천지 신도(31번 확진자, 2/18) 이후에는 지하철 승차 총승객수의 변화는 급속도록 감소했다. 감소와 더불어 정부에서는 사회적 거리두기를 실시했다.

국내 사회적 거리두기는 2월 말부터 시작했습니다.

KIST 연구팀이 환자 발생수를 시뮬레이션한 결과를 보면, 녹색 표시는 사회적 거리두기를 시행했을 때로, 2월 말 신천지 신도 이후 수백 명의 가장 많은 환자를 낸 뒤 줄어들 것으로 예측했습니다.

빨간색 선은 이에 따른 실제 예측 값입니다. 예측한것(초록색)과 같이 실제 확진자 수(빨간색)가 줄어드는 것을 보실수있습니다.

신천지 신도(31번 확진자, 2/18) 이후 2월 29일 하루 800여 명의 환자를 낸 이후 지속적으로 신규 환자 발생자 수가 감소했습니다.

사람들이 사회적 거리두기를 실천하지 않았다면 확진자의 수는 더 늘어났을 것입니다.

사회적 거리두기를 잘 실천함에 따라 확진자수가 줄어드는것을 보실수있습니다.

빨리 이 아픔이 없어지기 위해서는 모두의 노력이 필요합니다.

앞으로도 사회적 거리두기를 잘 실천하면서 이번 아픔이 빨리 없어지기를 바랍니다.

대구는 아직 공공데이터 포털에 다 올라오지 않아 자료가 올라오는대로 차차 업로드 하겠습니다.

'작은비버의 성장과정 > 과제 및 성장기' 카테고리의 다른 글

| [빅데이터] kickstarter에서 Project에 큰 영향을 미치는 Feature 확인하기(1. 상세사이트 링크 수집) (0) | 2020.08.30 |

|---|---|

| [프로젝트]주제 Hate Speech Detection_2020(++ 실험 결과, Word Attention visualization) (1) | 2020.06.03 |

| 공공데이터 API를 사용한 데이터 추출 (1) | 2020.05.01 |

| [프로젝트]주제 Public reaction during pandemic (0) | 2020.04.30 |

| [프로젝트]HateSpeech Dataset(2019) (0) | 2019.12.23 |